简介

近年来,基于新颖性的探索方法在这种稀疏奖励设置中表现出色。这些方法通常依赖于观测的生成模型或预测模型来估计状态的新颖性,例如生成未来状态的模型或状态密度模型。然而,当观测数据是高维度和复杂的(例如原始图像)时,训练这类生成模型或预测模型非常困难。

为了解决这一挑战,本文提出了一种新颖性检测算法——EX2 (Exploration with Exemplar Models for Deep Reinforcement Learning)。EX2的核心思想是完全基于判别式训练的范例模型来估计状态的新颖性。具体来说,EX2训练分类器来区分每个已访问的状态与其他所有状态。直观地,如果一个状态与训练中看到的其他状态更容易区分,那么它可能是一个新颖的状态。

本文的主要贡献包括:

- 提出了一种基于判别式训练范例模型的新颖性检测算法,用于强化学习中的探索。

- 证明了这种判别式建模方式可以对应于隐式密度估计,从而将该直觉与理论上严谨的基于计数的探索框架相结合。实验表明,在简单领域,隐式估计的密度能很好地估计底层状态密度,而无需任何显式生成训练。

- 提出了范例模型训练的摊销(amortization)方法,以避免分类器数量随状态数量增长的问题,使该方法变得实用且可扩展。

- 在多个流行基准任务上,包括挑战性的VizDoom基准(具有复杂的第一人称观测),实现了具有竞争力的结果,并在VizDoom上达到了最先进的性能。这表明隐式密度估计在处理复杂图像观测方面优于显式生成模型。

方法

EX2算法的核心在于利用判别式范例模型进行隐式密度估计,并以此提供内在激励信号,指导强化学习智能体进行探索。

范例模型(Exemplar Models)

为了避免对显式生成模型的需求,EX2使用范例模型来估计新颖性。给定一个数据集 $X = {x_1, \dots, x_n}$,一个范例模型由一组 $n$ 个分类器或判别器 ${D_{x_1}, \dots, D_{x_n}}$ 组成,每个数据点对应一个分类器。每个独立的判别器 $D_{x^*}$ 都被训练来将单个正例数据点 $x^*$(即“范例”)与数据集 $X$ 中的其他点区分开来。这种方法的直觉是,如果一个状态很容易与之前看到的所有其他状态区分开来,那么它很可能是新颖的。

在训练时,每个判别器 $D_{x^*}$ 使用一个平衡数据集,其中一半数据是范例 $x^*$,另一半来自背景分布 $P_X(x)$。判别器被训练以通过最大似然估计一个伯努利分布 $D_{x^*}(x) = P(x=x^*|x)$。目标是优化以下交叉熵损失:

$$ D_{x^*} = \arg \max_{D \in \mathcal{D}} \left( E_{\delta_{x^*}}[\log D(x)] + E_{P_X}[\log (1-D(x))] \right) $$范例模型作为隐式密度估计

本文的关键技术贡献之一是展示了判别式训练的范例模型如何用于隐式密度估计。 对于一个离散分布 $P_X(x)$,最优判别器 $D_{x^*}$ 满足:

$$ D_{x^*}(x) = \frac{\delta_{x^*}(x)}{\delta_{x^*}(x) + P_X(x)} $$当在范例 $x^*$ 处评估时,有:

$$ D_{x^*}(x^*) = \frac{1}{1 + P_X(x^*)} $$由此,我们可以从最优判别器的输出中恢复数据点 $x^*$ 的概率 $P_X(x^*)$:

$$ P_X(x^*) = \frac{1-D_{x^*}(x^*)}{D_{x^*}(x^*)} $$在连续域中,$\delta_{x^*}(x^*)$ 趋于无穷大,导致 $D(x) \to 1$,使得无法直接通过上述公式恢复 $P_X(x)$。为了解决这个问题,EX2通过在训练时向范例 $x^*$ 添加噪声 $\epsilon \sim q(\epsilon)$ 来平滑delta函数。即使我们不知道噪声方差,也能得到概率的比例估计:

$$ P_X(x^*) \propto \frac{1-D_{x^*}(x^*)}{D_{x^*}(x^*)} $$这种比例估计对于奖励加成来说是足够的,因为奖励加成对归一化因子是不变的。实际上,通过向背景分布 $P_X$ 也添加噪声来平滑,可以得到更适合探索的密度估计器,这等效于使用噪声分布作为核函数的核密度估计。

潜在空间平滑与次优判别器

对于图像等高维状态,直接在状态空间中添加噪声通常无法产生有意义的新状态,因为状态分布通常位于一个薄流形上。为解决此问题,EX2通过将噪声注入学习到的潜在空间来进行平滑。

该方法引入了一个潜在变量 $z$,并训练一个编码器分布 $q(z|x)$ 和一个潜在空间分类器 $p(y|z)$。同时,编码器分布会受到正则化,使其接近一个先验分布 $p(z)$ (在本文中是标准高斯分布)。这个目标函数旨在最大化分类准确性,同时通过潜在空间传递尽可能少的信息。这使得 $z$ 仅捕获 $x$ 中对于区分范例最具信息量的变异因素,从而使噪声保留在状态流形上。

此外,即使不显式添加噪声,次优判别器也会引入一种平滑。当判别器难以区分两个状态 $x$ 和 $x'$ 时,它会平均化“无限强大”判别器的输出。这种平滑来自判别器的归纳偏置,通常对模型有利。

EX2探索算法

EX2通过将隐式密度估计集成到基于计数的探索框架中。为了将基于计数的探索思想应用于连续或高维状态空间,EX2使用范例模型来近似状态访问计数 $N(s) = nP(s)$,其中 $P(s)$ 是训练期间访问状态的分布,而 $n$ 是回放缓冲区 $B$ 的大小。回放缓冲区 $B$ 是一个FIFO队列,用于存储先前的访问状态,这些状态作为训练的背景分布。

算法通过向标准奖励 $R(s, a)$ 添加一个与状态新颖性相关的奖励加成 $f(D_s(s))$ 来激励探索:

$$ R'(s, a) = R(s, a) + \beta f(D_s(s)) $$其中 $\beta$ 是一个超参数。在实验中,作者使用了启发式奖励加成 $-\log p(s)$,对于离散域也可以使用 $1/\sqrt{N(s)}$。

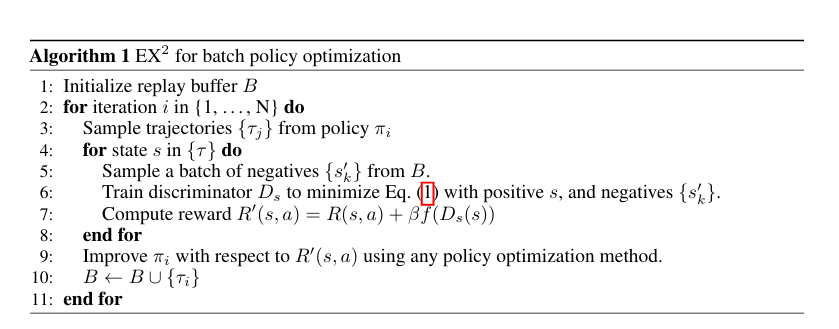

EX2 批处理策略优化算法

模型架构与摊销

为了处理图像等复杂观测,EX2使用神经网络实现范例模型,图像域使用卷积网络。为了降低为每个范例训练大型分类器的计算成本,本文提出了两种摊销计算的方法:

-

摊销多范例模型 (Amortized Multi-Exemplar Model):

- 不为每个范例训练一个独立的分类器,而是训练一个单个模型,该模型以范例 $x^*$ 为条件。

- 在潜在空间表示中,分类器形式为 $p(y|z, z^*) = D(z, z^*)^y(1-D(z, z^*))^{1-y}$,其中 $z^*$ 是 $x^*$ 的编码表示。

- 优点:无需在每次迭代从头开始训练新的判别器,并为新状态的密度估计提供一定程度的泛化能力。该架构类似于一个比较算子。

-

K-范例模型 (K-Exemplar Model):

- 训练时使用一批 $K$ 个正例 ${x_1, \dots, x_K}$,并从中均匀采样。

- 这种模型可以在“每个状态一个判别器”的最强模型 ($K=1$) 和“所有状态一个判别器”的最弱模型 ($K=|states|$) 之间平滑插值。

- 在实验中,作者将轨迹中相邻的状态分批给同一个判别器,这相当于一种时间上的正则化,假设时间上相邻的状态是相似的。

- 大多数神经网络层在判别器之间共享,只有最后一层线性层允许不同,这迫使共享层学习一个联合特征表示。

- 对于训练时均匀采样的 $K$ 个正例,最优判别器 $D^*_B(x)$ 在任何一个正例 $x$ 处满足: $$ D^*_B(x) = \frac{1}{1 + K P_X(x)} $$

EX2算法与生成对抗网络 (GANs) 有趣的关联。策略可以看作GAN的生成器,范例模型则作为判别器,试图将当前轨迹批次中的状态与之前状态进行分类。然而,与GAN中生成器试图欺骗判别器不同,EX2中生成器(策略)因帮助判别器(发现可区分的状态)而获得奖励,这是一种合作博弈。同时,策略也在与时间的进程竞争:当一个新颖状态被频繁访问时,回放缓冲区将被该状态饱和,从而失去其新颖性,这促使策略不断寻求新状态以获得探索奖励。

实验

实验旨在将EX2方法与朴素探索策略以及近期基于显式密度模型的深度强化学习探索方案进行比较。策略优化方法采用了TRPO (Trust Region Policy Optimization)。

实验任务

实验包括低维基准任务和复杂图像任务:

- 低维任务:

- 2D 迷宫 (2D Maze):二维连续迷宫,奖励稀疏,用于可视化状态访问密度。

- SparseHalfCheetah 和 SwimmerGather:OpenAI gym 中的连续控制任务,奖励稀疏,观测维度中等(分别为33和20维)。

- 高维图像任务:

- 三款Atari游戏 (Freeway, Frostbite, Venture):奖励稀疏,图像相对简单,2D,视觉多样性低,有利于生成模型。

- VizDoom (DoomMyWayHome+):最具挑战性的任务,第一人称视角,3D视觉,部分可观测性,相机运动,奖励极其稀疏。智能体初始位置离目标最远。

对比方法

EX2的两种变体(K-范例和摊销模型)与以下方法进行比较:

- 标准随机探索 (TRPO with Gaussian exploration)。

- 基于RBF核的核密度估计 (KDE)。

- 基于贝叶斯神经网络生成模型的VIME (Variational Information Maximizing Exploration)。

- 基于自动编码器学习的潜在空间哈希方法 (Hashing)。

实验发现和结论

-

2D 迷宫:

- EX2模型(图2a)产生的密度估计合理且经过平滑,与经验离散分布(图2b)相比,能很好地估计真实经验分布。

- 在探索性能上,EX2的两种变体与VIME和KDE表现相似,优于无法找到稀疏奖励目标的标准TRPO。

-

连续控制任务 (SwimmerGather 和 SparseHalfCheetah):

- EX2在这些中维任务上表现出竞争力,即使这些任务中显式生成模型应该表现良好。

- 在SwimmerGather上,EX2、VIME和Hashing显著优于朴素TRPO和KDE。

- 在SparseHalfCheetah上,摊销EX2显著优于所有其他方法。

- 这表明EX2获得的隐式密度估计能提供与各种显式密度估计技术相当的探索奖励。

-

图像控制任务 (Atari 和 Doom):

- EX2能够在高维视觉环境中产生连贯的探索行为,并在Atari游戏上与表现最佳的现有方法匹配。

- 最重要的是,在最具挑战性的DoomMyWayHome+任务上,EX2的性能远远超过所有先前的探索技术,能够引导智能体穿过多个房间到达目标。

- 结论:这突出显示了隐式密度估计的优势。虽然显式密度估计器在Atari游戏中的简单、清晰图像上能取得良好结果,但它们在VizDoom中更复杂的、第一人称视角观测上开始遇到困难,而EX2能够提供合理的密度估计并取得优异结果。

权衡与未来工作

作者讨论了判别式训练的范例模型和生成模型之间的权衡。两种方法在欠拟合时都会给出平坦的奖励加成,而在过拟合时会对所有新状态给出高奖励。范例模型在高维观测下容易过拟合(特别是摊销模型作为比较器时),而通过增加潜在空间中注入的噪声量则容易欠拟合。然而,范例模型提供了一个单一的超参数(噪声大小)来在这些极端之间进行插值,而无需改变模型本身,这提供了更好的平滑控制。

未来的工作可能包括根据可用数据量自动调整平滑因子。此外,隐式密度估计与范例模型可能在其他密度估计应用中发挥作用,探索这些应用也是一个令人兴奋的方向。